Crawl website có mật khẩu (password-protected crawling) là kỹ thuật cho phép bạn truy cập và quét nội dung nằm sau lớp đăng nhập, thường dùng cho website đang phát triển hoặc khu vực dành riêng cho thành viên. Việc crawl đúng cách giúp bạn kiểm tra nội dung, đánh giá SEO, tối ưu cấu trúc sitemap và phát hiện vấn đề về khả năng truy cập. Trong bài viết này, Lenart sẽ hướng dẫn cách crawl website bảo mật mật khẩu một cách an toàn – chính xác – không ảnh hưởng dữ liệu, giúp bạn bổ sung thêm kiến thức SEO quan trọng khi xử lý các website private.

1. Cách Crawl Website Có Mật Khẩu bằng Web Forms Authentication

Trong phiên bản 23.1, SEO Spider tiếp tục cải tiến tính năng Forms Based Authentication, giúp bạn đăng nhập qua biểu mẫu giống người dùng thật để crawl các khu vực cần xác thực. Giúp bạn có thể crawl các phiên bản phát triển của website hoặc những trang có đăng nhập ngay trong trang, ví dụ như một site WordPress riêng tư. Trước đó, Screaming Frog đã hỗ trợ xác thực theo chuẩn cơ bản như basic và digest authentication, nhưng với xác thực web forms, bạn có thể crawl gần như mọi phần nội dung ẩn sau đăng nhập. Tính năng này rất mạnh nên cần sử dụng cẩn trọng. SEO Spider tự động gửi request đến các URL được phát hiện trong quá trình crawl. Khi bật JavaScript rendering, công cụ mô phỏng trình duyệt để tải nội dung động và có thể gây ra thao tác ngoài ý muốn như đăng xuất, kích hoạt plugin, tạo hoặc chỉnh sửa nội dung nếu tài khoản có quyền cao.

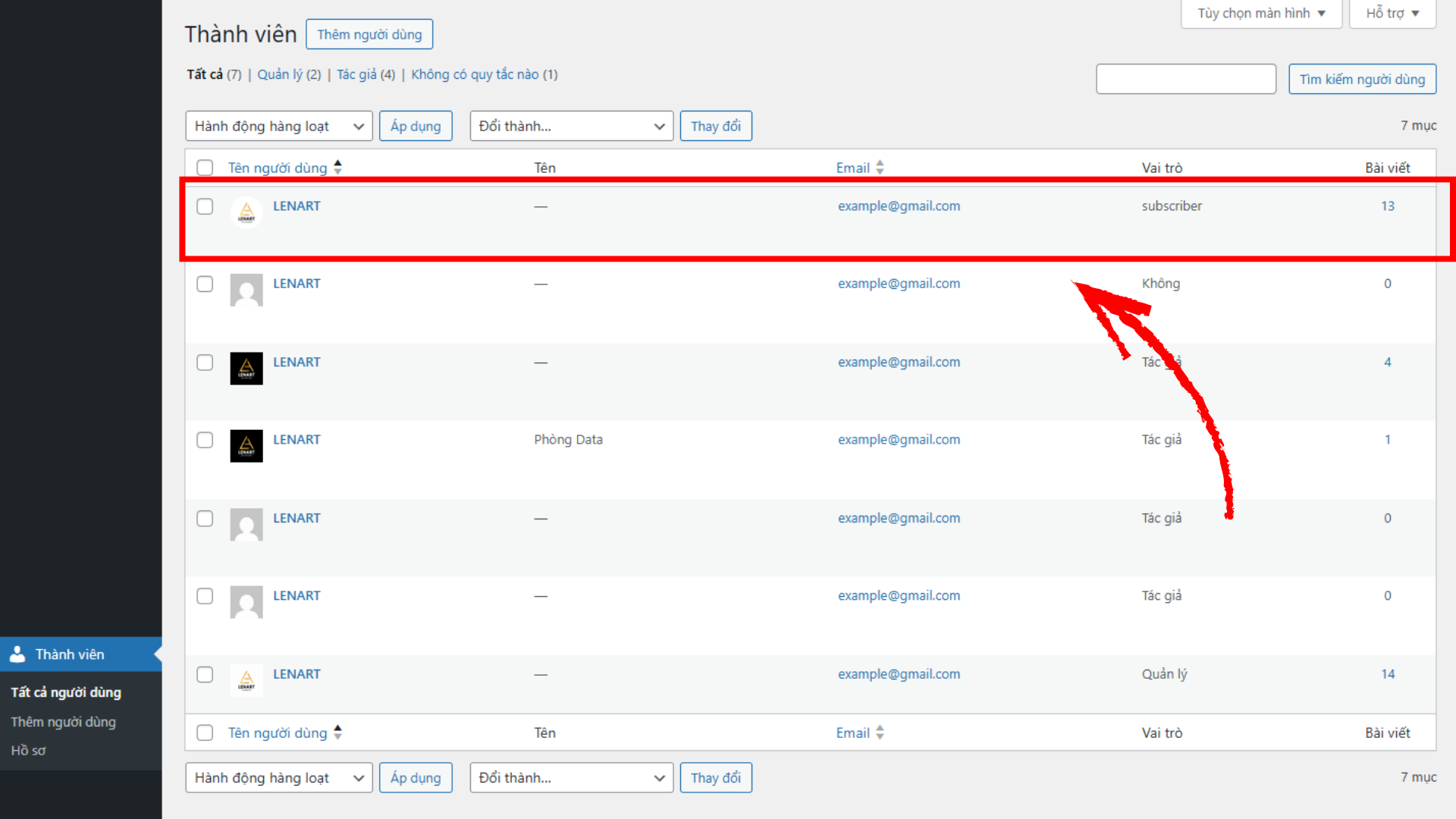

Cách an toàn nhất để tránh SEO Spider gây ra sai sót trên website của bạn là đăng nhập bằng một tài khoản chỉ có quyền đọc, không có quyền ghi. trong quá trình thử nghiệm, Lenart đã tạo một tài khoản riêng dành cho Spider với vai trò là ‘subscriber’ (người đăng ký thông thường).

Trên website thử nghiệm, chúng tôi sử dụng plugin My Private Site của WordPress để bảo vệ toàn bộ site bằng mật khẩu, chỉ cho phép truy cập với người dùng đã đăng nhập. Bạn có thể cần liên hệ với quản trị viên website để được cấp một tài khoản chỉ đọc cho site phát triển của bạn.

Bạn nên loại trừ các URL nhạy cảm bằng tính năng Exclude của SEO Spider để tránh crawl vào khu vực quản trị, như URL đăng xuất và thư mục /wp-admin/. Ví dụ regex:

http://example.com/wp-login\.php\?action=logout.*

http://example.com/wp-admin/.*

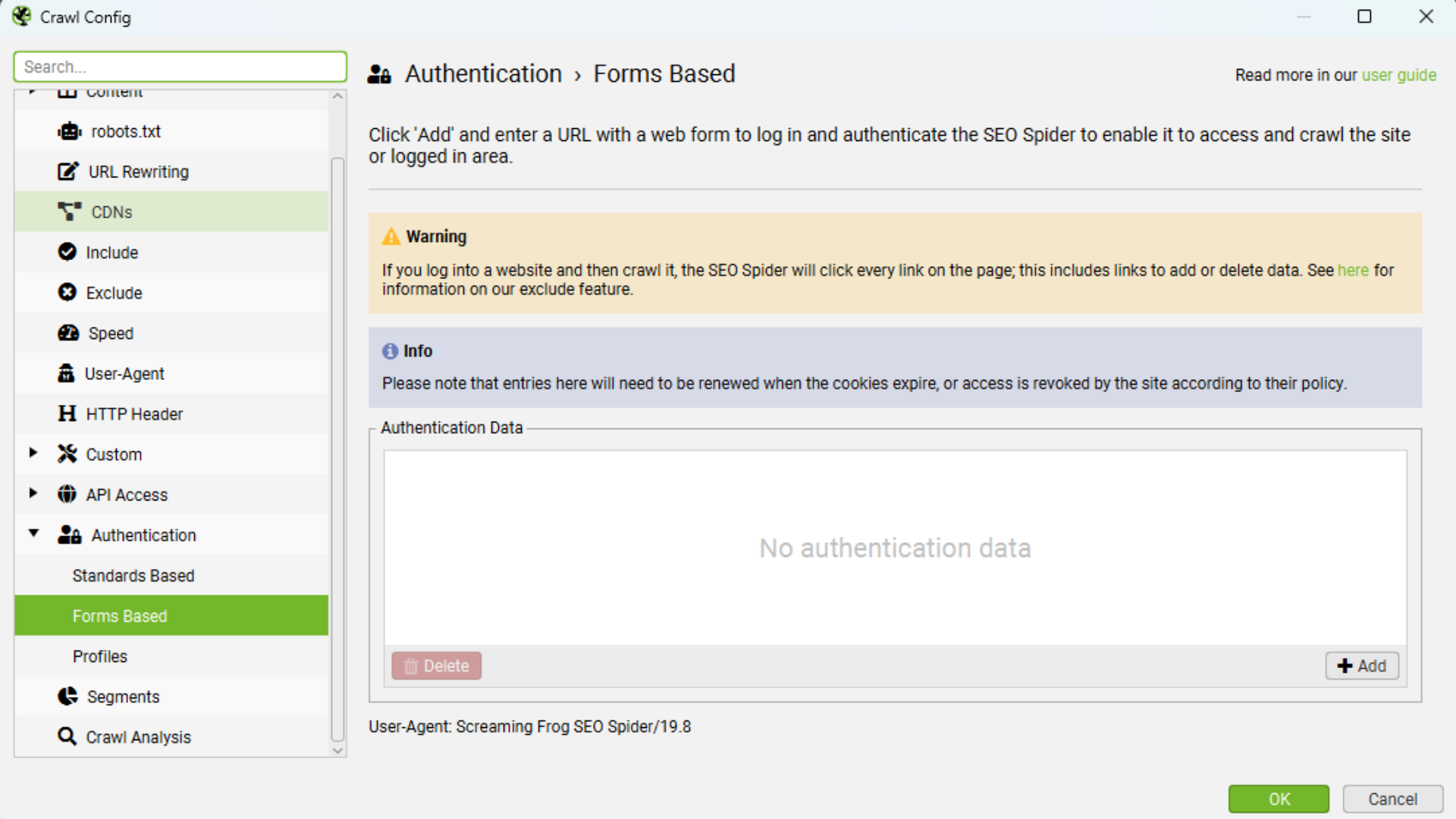

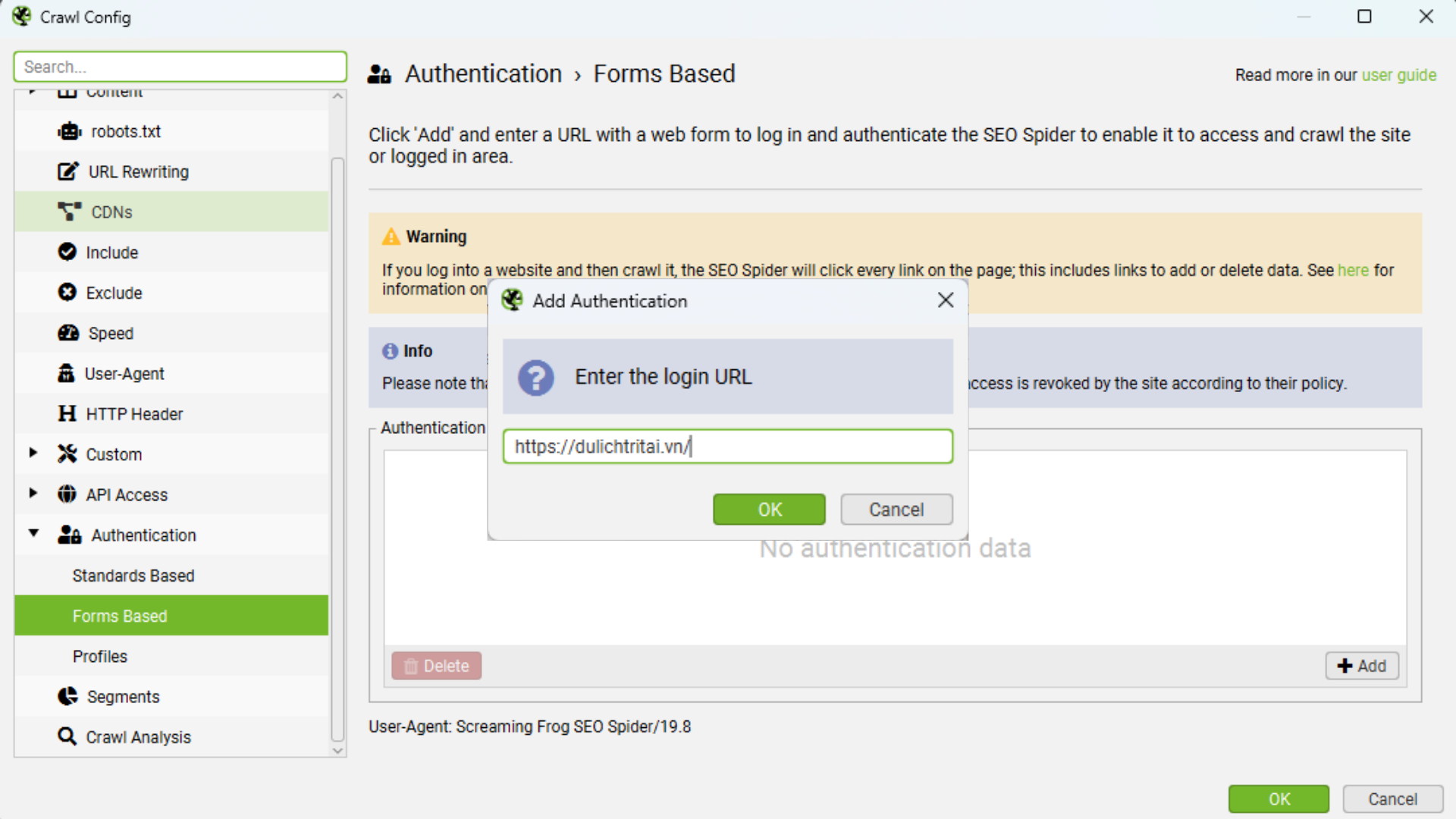

Thiết lập Exclude đúng cách giúp hạn chế request không mong muốn đến các URL backend. Khi đã tạo tài khoản an toàn cho SEO Spider và thiết lập các loại trừ, bạn tiến hành đăng nhập bằng cách vào ‘Configuration -> Authentication’, chọn tab ‘Forms Based’, nhấn nút ‘Add’, nhập URL trang đăng nhập. Mini browser trong bản 23.1 sẽ hiển thị giao diện đăng nhập giống người dùng thật và lưu lại session/cookie sau khi bạn đăng nhập thành công.

Sau khi đăng nhập xong, nhấn ‘OK’ và đóng cửa sổ cấu hình. Bạn có thể bắt đầu crawl và quan sát SEO Spider thám hiểm khu vực bảo mật, nơi mà trước đây không thể truy cập.

2. Lưu Ý Khi Crawl Website Có Mật Khẩu

Trong thử nghiệm với tài khoản admin, SEO Spider đã gửi nhiều request không mong muốn chỉ sau khoảng 30 phút crawl, như thay đổi cấu hình, kích hoạt plugin hoặc chỉnh sửa nội dung. Công cụ thậm chí có lúc tự động đăng xuất. Điều này cho thấy việc crawl bằng tài khoản có quyền cao rất rủi ro và cần hạn chế.

3. Website bảo mật mật khẩu là gì và lý do sử dụng

Website được bảo vệ bằng mật khẩu là các trang web giới hạn quyền truy cập. Bạn cần nhập mật khẩu (và thường cả tên đăng nhập hợp lệ) để có thể xem nội dung. Có những website được bảo vệ toàn bộ, còn một số trang chỉ bảo vệ một khu vực như dành riêng cho nhân viên hoặc thành viên khi đó bạn mới crawl website có mật khẩu được

Có thể bạn sẽ thắc mắc tại sao một website lại cần thiết lập mật khẩu bảo vệ, vì rõ ràng bảo mật sẽ hạn chế lượng người truy cập, trong khi mục tiêu của website là thu hút càng nhiều khách càng tốt. Nhưng trên thực tế, có ba lý do chính khiến nhà quản trị web cần đặt mật khẩu bảo vệ:

- Phát triển website: Khi website đang trong quá trình thiết kế, xây dựng hay chỉnh sửa lớn, cần cho phép nhân viên truy cập mà không muốn khách hàng xem.

- Nội dung riêng tư: Một số website có phần nội dung chỉ dành cho thành viên đăng ký (có thể là miễn phí hoặc trả phí). Ví dụ ngân hàng cho phép khách truy cập thông tin chung, nhưng tài khoản trực tuyến thì phải đăng nhập.

- Bảo mật chức năng, quản trị: Các khu vực quản lý hoặc kho tài nguyên riêng cho nhân viên được bảo vệ, tránh rủi ro mất thông tin quan trọng. Đây cũng là cách để chia sẻ file và thông tin hiệu quả hơn email trong doanh nghiệp.

4. Tại sao cần crawl website bảo mật mật khẩu?

Có thể bạn nghĩ crawl website có mật khẩu thì trang bảo vệ như vậy là không hợp pháp, nhưng có nhiều lý do hoàn toàn chính đáng để bạn phải crawl, ví dụ:

- Tạo danh sách nội dung: Khi site đang phát triển hoặc thay đổi, cần kiểm soát xem nội dung nào đã được đăng tải, đảm bảo đầy đủ.

- Kiểm tra nội dung (content audit): Từ danh sách nội dung, rà soát xem có thiếu, hỏng hay chưa được gắn thẻ chuẩn để SEO hay không.

- Tạo sitemap trực quan: Giúp người quản lý và SEO nhìn thấy tổng quan cấu trúc, điều chỉnh bố cục trước khi site chính thức chạy.

- Kiểm tra SEO: Crawl site trong trạng thái bảo mật giúp bạn xem website hiển thị ra sao với công cụ tìm kiếm, xác nhận meta tag, sitemap có chuẩn chưa, nâng cao khả năng lên top.

- Đảm bảo khả năng truy cập (Accessibility): Đảm bảo ngay cả những trang bảo vệ vẫn có thể truy cập dễ dàng cho người khuyết tật hoặc thiết bị đặc biệt.

5. Các Lợi Ích Khi Crawl Website Bảo Mật

Crawl website có mật khẩu mang lại nhiều lợi ích quan trọng cho người quản lý và phát triển site. Trước hết, việc tạo ra một inventory (danh sách đầy đủ các nội dung trên website) giúp bạn kiểm soát tốt hơn những gì đã có, nhất là khi site còn trong quá trình xây dựng hoặc thay đổi.

Ngoài ra, crawl còn giúp kiểm tra SEO toàn diện, đảm bảo các thẻ meta, sitemap, và cấu trúc website được thiết lập chính xác để tối ưu hóa khả năng xuất hiện trên công cụ tìm kiếm. Không chỉ dành cho SEO, crawl còn giúp đánh giá tính khả dụng (accessibility) của website, bao gồm khả năng truy cập của người dùng có khuyết tật hoặc sử dụng các thiết bị hỗ trợ đặc biệt, ngay cả khi trang được bảo mật.

6. So sánh Basic – Digest – Forms Authentication khi Crawl Website Có Mật Khẩu

Khi crawl website có mật khẩu, bạn sẽ gặp ba cơ chế xác thực phổ biến nhất: Basic Authentication, Digest Authentication và Forms Authentication. Mỗi loại hoạt động theo nguyên tắc khác nhau và ảnh hưởng trực tiếp đến cách công cụ crawl truy cập nội dung. Bảng dưới đây giúp bạn so sánh nhanh để lựa chọn đúng phương pháp cho website của mình.

| Tiêu chí | Basic Authentication | Digest Authentication | Forms Authentication |

| Cơ chế hoạt động | Gửi username:password mã hóa Base64 trong header HTTP | Gửi hash (MD5) của thông tin đăng nhập + nonce | Người dùng submit form HTML → server tạo session/cookie |

| Mức độ bảo mật | Thấp (dễ decode nếu không dùng HTTPS) | Trung bình (bảo mật hơn Basic) | Cao (dựa trên session, cookie, CSRF token) |

| Độ phổ biến | Cao trong môi trường server / htpasswd | Ít phổ biến hơn | Phổ biến nhất trong website thực tế |

| Dễ thiết lập | Rất dễ | Trung bình | Phức tạp hơn vì cần mô phỏng đăng nhập |

| Cách crawler hỗ trợ | Hầu hết crawler hỗ trợ tốt | Hỗ trợ nhưng ít gặp | SEO Spider/ Sitebulb/ Botify hỗ trợ qua Forms Authentication |

| Khi nào dùng | Bảo vệ tạm thời staging, API đơn giản | Tránh gửi mật khẩu rõ ràng nhưng vẫn theo chuẩn HTTP | Các website có trang đăng nhập: WordPress, PHP login, membership site… |

| Ưu điểm | Nhanh, gọn, dễ thiết lập | Bảo mật hơn Basic | Mô phỏng y như người dùng thật, truy cập được nội dung private |

| Nhược điểm | Rất dễ bị sniff nếu không có HTTPS | Thiết lập phức tạp, ít dùng | Dễ gây thao tác ngoài ý muốn khi crawl nếu dùng tài khoản có quyền cao |

| Ứng dụng trong crawl | Dễ thiết lập nhất khi crawl | Hiếm gặp nhưng vẫn hỗ trợ | Phổ biến nhất để crawl website private hoặc staging site |

7. Thách Thức Phổ Biến Khi Crawl Website Có Xác Thực

Khi crawl các website yêu cầu xác thực, bạn sẽ gặp một số khó khăn phổ biến như duy trì session đăng nhập, xử lý cookie và token để truy cập liên tục mà không bị đăng xuất.

Ngoài ra, nhiều website giới hạn số lần truy cập hoặc bắt buộc các điều kiện bảo mật cao, gây khó khăn cho công cụ crawl trong việc lấy đủ dữ liệu. Việc xử lý đúng các cơ chế xác thực, đồng thời tránh ảnh hưởng đến trải nghiệm người dùng và hệ thống quản trị website cũng là những thách thức cần được cân nhắc và giải quyết triệt để.

Qua bài viết này, bạn đã hiểu rõ hơn cách crawl website có mật khẩu cũng như các lợi ích và thách thức khi triển khai kỹ thuật này. SEOLENART tin rằng với phương pháp phù hợp và lựa chọn công cụ hợp lý, bạn sẽ nâng cao hiệu quả quản lý nội dung, tối ưu SEO kỹ thuật và bảo vệ an toàn cho website của mình.