Trong quá trình crawl website, việc hiểu rõ các http status code crawl là vô cùng quan trọng để nhận biết trạng thái phản hồi của từng URL và xử lý sự cố phù hợp. Các mã trạng thái HTTP không chỉ cho thấy trang có được truy cập thành công hay không, mà còn giúp phát hiện nhanh các lỗi như bị chặn bởi robots.txt, chuyển hướng không hợp lý, hay lỗi server. LENART sẽ chia sẻ bài viết này sẽ giúp bạn nắm bắt cơ bản về các mã trạng thái phổ biến trong crawl cùng những lưu ý quan trọng để tối ưu hiệu quả quét trang với công cụ Screaming Frog.

1. Giới thiệu về HTTP Status Code khi crawl website

Khi sử dụng Screaming Frog SEO Spider để quét (crawl) website, nếu công cụ chỉ quét được một trang hoặc không quét như mong đợi, bạn nên kiểm tra cột Status và Status Code đầu tiên để xác định nguyên nhân.

Status trong giao thức Hypertext Transfer Protocol (HTTP) gồm một mã số (status code) và tương ứng với một đoạn chữ mô tả trạng thái phản hồi của server. Khi một URL được đưa vào SEO Spider và quá trình crawl bắt đầu, mã trạng thái sẽ hiện trong cột status code, còn đoạn chữ mô tả hiện trong cột status trong tab mặc định.

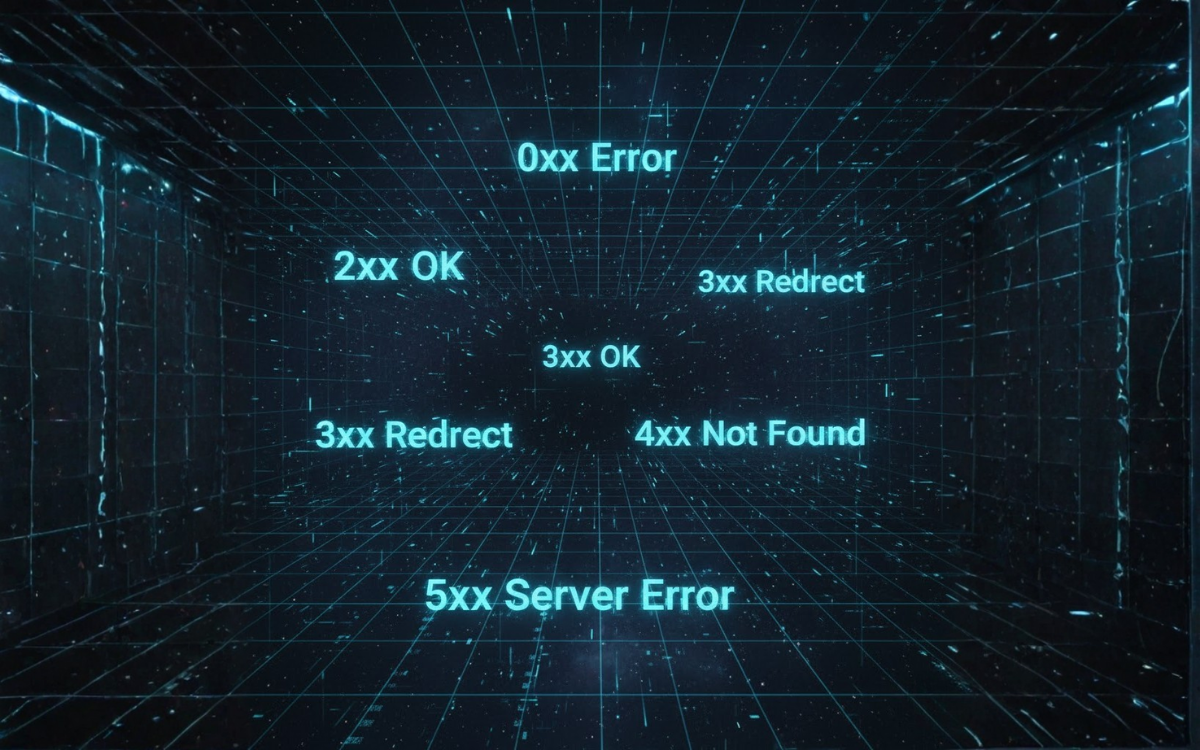

Các mã trạng thái phổ biến và ý nghĩa khi crawl trang bao gồm:

0 – Blocked By Robots.txt: Bị chặn bởi file robots.txt của website, SEO Spider không thể truy cập URL. 0 – DNS Lookup Failed: Không tìm thấy tên miền do lỗi DNS. 0 – Connection Timeout: Kết nối tới server bị hết thời gian chờ. 200 – OK: Yêu cầu thành công, trang có thể được crawl. 301 – Moved Permanently / 302 – Moved Temporarily: Trang được chuyển hướng vĩnh viễn hoặc tạm thời. 400 – Bad Request / 403 – Forbidden: Yêu cầu sai hoặc bị cấm truy cập. 404 – Page Not Found: Trang không tồn tại hoặc đã bị gỡ bỏ. 429 – Too Many Requests: Quá nhiều yêu cầu gửi đến server. 500 – Internal Server Error / 502 – Bad Gateway / 503 – Service Unavailable: Lỗi từ phía server.

Việc hiểu rõ các mã này giúp bạn xác định nguyên nhân vì sao website không được crawl đúng, từ đó có giải pháp xử lý phù hợp như chỉnh sửa file robots.txt, kiểm tra DNS, tối ưu chuyển hướng hoặc xử lý lỗi server. SEO Spider cũng cung cấp bộ lọc và báo cáo giúp bạn kiểm tra từng nhóm lỗi để dễ dàng theo dõi và sửa chữa.

2. Bảng mã HTTP Status Code phổ biến khi crawl (http status code crawl) bằng SEO Spider

Dưới đây là bảng tổng hợp các http status code crawl phổ biến cùng ý nghĩa để bạn dễ dàng hiểu và xử lý khi sử dụng Screaming Frog SEO Spider.

| Mã lỗi / Trạng thái | Nguyên nhân phổ biến | Giải pháp nhanh (Nên thử) |

| 0 – Blocked by robots.txt | robots.txt chặn | Ignore robots.txt hoặc chỉnh robots.txt để cho phép crawl |

| 0 – DNS Lookup Failed | Lỗi DNS, tên miền không tìm thấy | Kiểm tra truy cập trên trình duyệt; thêm exception cho firewall/antivirus |

| 0 – Connection Timeout | Server phản hồi chậm | Tăng timeout, giảm tốc độ crawl, tắt proxy, tạo exception firewall |

| 0 – Connection Refused | Server/CDN từ chối bot | Đổi User-Agent → Chrome; bật JS Rendering; thêm allowlist IP/User-Agent |

| 0 – Connection Error / No Response | Lỗi mạng hoặc proxy sai | Tắt Proxy trong cấu hình SEO Spider |

| 200 – OK nhưng không crawl tiếp | Trang dùng JS, nofollow hoặc yêu cầu cookie | Bật JavaScript Rendering; follow nofollow links; bật cookies |

| 301 / 302 – Redirect | Trang chuyển hướng | Kiểm tra loop redirect; bật Crawl All Subdomains; Allow Cookies |

| 400 / 403 / 406 | Server từ chối truy cập | Đổi User-Agent → Chrome; bật JS Rendering; allowlist IP/User-Agent |

| 404 / 410 | Trang không tồn tại | Kiểm tra lại trong trình duyệt; đổi user-agent nếu cần |

| 429 – Too Many Requests | Gửi quá nhiều request | Giảm speed, thêm delay, đổi user-agent, crawl lúc ít traffic |

| 500 / 502 / 503 | Lỗi server | Thử user-agent khác (Chrome/Googlebot); kiểm tra server |

3. 0 – Bị chặn bởi robots.txt

Mã trạng thái ‘0’ trong SEO Spider cho biết không nhận được phản hồi HTTP từ server. Trạng thái này cung cấp manh mối chính xác về lý do vì sao không có mã trạng thái được trả về.

Trong trường hợp này, điều đó cho thấy file robots.txt của trang web đang chặn user agent của SEO Spider truy cập URL được yêu cầu. Do đó, phản hồi HTTP thực tế không được hiển thị vì chỉ thị disallow.

Điều cần kiểm tra: Điều gì đang bị chặn trong robots.txt của trang web? (Thêm /robots.txt vào tên miền con của URL được crawl).

Điều nên thử: Thiết lập SEO Spider để bỏ qua robots.txt (Configuration > Robots.txt > Settings > Ignore Robots.txt) hoặc sử dụng cấu hình robots.txt tùy chỉnh để cho phép crawl.

Lý do: SEO Spider mặc định tuân thủ các chỉ thị disallow trong robots.txt.

4. 0 – Lỗi DNS Lookup Failed

Website không thể được tìm thấy, thường là do trang web không tồn tại hoặc kết nối internet của bạn không khả dụng.

Điều cần kiểm tra: Tên miền đã được nhập chính xác chưa.

Điều cần kiểm tra: Trang web có thể xem được trên trình duyệt của bạn không.

Lý do: Nếu bạn không thể xem trang trên trình duyệt, có thể bạn đang gặp sự cố về kết nối máy tính hoặc mạng. Nếu bạn có thể xem trang, thì có thể một phần mềm như antivirus hoặc tường lửa đang chặn SEO Spider kết nối internet và bạn cần thiết lập ngoại lệ cho nó.

5. 0 – Hết thời gian kết nối (Connection Timeout)

Một lỗi hết thời gian kết nối xảy ra khi SEO Spider không thể nhận được phản hồi HTTP từ server trong khoảng thời gian quy định (mặc định là 20 giây).

Điều cần kiểm tra: Bạn có thể xem trang web trong trình duyệt không, trang có tải chậm không?

Điều nên thử: Nếu trang tải chậm, hãy thử tăng response timeout và giảm tốc độ crawl.

Lý do: Việc này cho phép SEO Spider có nhiều thời gian hơn để nhận dữ liệu và giảm tải cho server.

Điều cần kiểm tra: Có thể crawl các trang web khác không? (ví dụ: bbc.co.uk hoặc screamingfrog.co.uk).

Điều nên thử: Thiết lập ngoại lệ cho SEO Spider trong phần mềm firewall/antivirus (hoặc hỏi đội IT của bạn).

Lý do: Nếu lỗi xảy ra với tất cả website thì có thể là vấn đề tại máy tính hoặc mạng của bạn.

Điều cần kiểm tra: Proxy có đang được bật không? (Configuration > System > Proxy)

Điều nên thử: Nếu bật, hãy tắt Proxy đi.

Lý do: Nếu thiết lập proxy không đúng, SEO Spider có thể không gửi hoặc nhận yêu cầu được.

6. 0 – Kết nối bị từ chối (Connection Refused)

Mã trạng thái ‘Connection Refused’ xảy ra khi nỗ lực kết nối của SEO Spider bị từ chối tại một điểm giữa máy tính của bạn và trang web.

Điều cần kiểm tra: Bạn có thể crawl các trang web khác không? (bbc.co.uk và screamingfrog.co.uk là các trang tốt để kiểm tra).

Điều cần kiểm tra: Thiết lập ngoại lệ cho SEO Spider trong phần mềm firewall/antivirus (hãy tham khảo đội IT của bạn).

Lý do: Nếu lỗi xảy ra với mọi trang web, có thể vấn đề đến từ máy tính hoặc mạng của bạn.

Điều cần kiểm tra: Bạn có thể xem trang web trong trình duyệt không hoặc nó có trả về lỗi tương tự?

Điều nên thử: Nếu trang có thể xem được, hãy đặt Chrome làm user agent cho SEO Spider (Configuration > User-Agent). Bật JavaScript Rendering (Configuration > Spider > Rendering) cũng có thể cần thiết.

Nếu vẫn không hoạt động, bạn có thể cần thêm địa chỉ IP và user-agent ‘Screaming Frog SEO Spider’ vào danh sách cho phép (allowlist) trong cài đặt bảo mật CDN của trang web.

Lý do: Máy chủ có thể từ chối yêu cầu của SEO Spider nhằm bảo vệ hoặc kiểm soát các user-agent không xác định.

7. 0 – Lỗi kết nối / Không có phản hồi (Connection Error / No Response)

SEO Spider gặp khó khăn trong việc thiết lập kết nối hoặc nhận phản hồi.

Điều cần kiểm tra: Cấu hình proxy (Configuration > System > Proxy).

Điều nên thử: Nếu proxy đang bật, hãy tắt đi.

Lý do: Nếu thiết lập proxy không đúng, SEO Spider sẽ không gửi hoặc nhận được yêu cầu đúng cách.

Điều cần kiểm tra: Bạn có thể xem trang web trong trình duyệt không hoặc nó có lỗi tương tự?

Lý do: Nếu mạng hoặc trang web có vấn đề, trình duyệt cũng sẽ gặp lỗi tương tự.

8. 200 – OK

Trang web đã phản hồi thành công, tức không có lỗi ở quá trình nhận phản hồi từ server. Tuy nhiên, vấn đề có thể nằm ở nội dung trả về.

Mục điều cần kiểm tra

- Kiểm tra xem trang có chứa thẻ meta robots ‘nofollow’ hay các thuộc tính rel=’nofollow’ trên các liên kết không.

- Xem xét xem các liên kết có phải là JavaScript không bằng cách tắt JavaScript trên trình duyệt và xem lại.

- Kiểm tra các giới hạn crawl trong cấu hình như ‘Limit Search Depth’ và ‘Limit Search Total’.

- Kiểm tra xem trang có yêu cầu cookie không, bằng cách tắt cookie trên trình duyệt và thử xem có thay đổi.

- Kiểm tra phần ‘Content’ trong header HTTP để xác định loại nội dung trả về.

- Xem xét liệu có bất kỳ rào cản tuổi tác (age gate) nào không.

Mục điều nên thử:

- Bật tính năng [JavaScript Rendering] trong SEO Spider để crawler có thể đọc được nội dung và link từ JavaScript.

- Đặt SEO Spider theo dõi liên kết nofollow trong cấu hình.

- Cho phép cookie nếu trang cần.

- Thay đổi user agent sang Googlebot nếu trang phục vụ nội dung đặc biệt cho bots tìm kiếm.

- Kích hoạt JavaScript Rendering để xử lý các nội dung động hoặc có meta http-equiv trong thẻ head.

Mục Lý do:

- SEO Spider mặc định chỉ crawl mã nguồn HTML, không thực thi JavaScript, do đó có thể bỏ sót nhiều phần nội dung hoặc liên kết.

- Một số trang web phục vụ nội dung khác cho bots tìm kiếm, hoặc có cơ chế kiểm tra như yêu cầu cookie hay age gate, nên cần bật các tùy chọn tương ứng để lấy nội dung đầy đủ.

9. 301 – Chuyển hướng vĩnh viễn / 302 – Chuyển hướng tạm thời

Điều này có nghĩa URL được yêu cầu đã di chuyển và được chuyển hướng đến một vị trí khác.

Mục điều cần kiểm tra:

- Kiểm tra xem địa chỉ chuyển hướng đích là gì? Bạn có thể xem trong phần outlinks của URL trả về.

- Kiểm tra tab External để xem các chuyển hướng đến các tên miền khác hoặc các tên miền phụ không được crawl mặc định.

- Kiểm tra xem trang có yêu cầu cookies hay không bằng cách xem trang trên trình duyệt với cookies bị tắt.

Mục điều nên thử:

- Nếu URL đích giống với URL bắt đầu, bạn nên tham khảo hướng dẫn xử lý trong mục FAQ “Tại sao URL chuyển hướng chính nó” để xử lý vòng lặp chuyển hướng.

- Bật tùy chọn Crawl All Subdomains (Cấu hình > Spider) để cho phép SEO Spider crawl các subdomain khác nếu trang chuyển hướng sang đó.

- Trong phần cấu hình nâng cao (Cấu hình > Spider > Advanced Tab), bật Allow Cookies để cho phép SEO Spider chấp nhận cookies nếu trang sử dụng cookie để điều hướng.

Mục lý do:

- Vòng lặp chuyển hướng khiến SEO Spider không thể truy cập được trang HTML có thể crawl được.

- SEO Spider mặc định xử lý các tên miền phụ như trang bên ngoài nên không crawl nếu chuyển hướng sang khác subdomain.

- Nếu chuyển hướng sử dụng cookie mà SEO Spider không chấp nhận, sẽ không thể crawl trang được.

10. 400 – Bad Request / 403 – Forbidden / 406 – Not Acceptable

Server không thể hoặc từ chối xử lý yêu cầu, hoặc từ chối cho SEO Spider xem URL được yêu cầu.

Điều cần kiểm tra

- Bạn có thể xem trang đó trên trình duyệt không? Nó có trả về lỗi tương tự không?

Điều nên thử

- Nếu trang có thể xem được, hãy thử đặt Chrome làm user agent cho SEO Spider (Configuration > User-Agent).

- Bật JavaScript Rendering (Configuration > Spider > Rendering) để cho phép SEO Spider xử lý các trang có nội dung JavaScript động.

- Nếu vẫn không hoạt động, bạn có thể cần thêm địa chỉ IP và user agent ‘Screaming Frog SEO Spider’ vào danh sách cho phép (allowlist) trong cài đặt bảo mật CDN của trang web.

Lý do

Server có thể từ chối yêu cầu của SEO Spider do bảo mật, đặc biệt với các user agent không xác định hoặc không được chấp nhận.

11. 404 – Page Not Found / 410 – Removed

Server thông báo trang đã bị gỡ bỏ hoặc không tồn tại.

Điều cần kiểm tra

- URL có tải được trang bình thường trên trình duyệt không?

- Kiểm tra mã trạng thái của URL trên các công cụ khác như Web Sniffer, Rexswain hoặc plugin trình duyệt để đảm bảo mã lỗi không bị báo sai.

Điều nên thử

- Nếu trang hiển thị trên trình duyệt, hãy thử đổi user agent SEO Spider sang Chrome hoặc Googlebot (Configuration > User-Agent).

- Lưu ý rằng một số trang có thể chặn user agent giả mạo Googlebot.

Lý do

Trang có thể phục vụ mã lỗi để bảo vệ nội dung hoặc hạn chế các truy cập từ các user agent không xác định hoặc bot.

12. 429 – Quá nhiều yêu cầu

Máy chủ nhận được quá nhiều yêu cầu trong một khoảng thời gian ngắn.

Điều cần kiểm tra

- Bạn có thể truy cập trang web trên trình duyệt không? Trình duyệt có hiển thị lỗi tương tự không?

Điều nên thử

- Giảm tốc độ crawl bằng cách giảm số luồng (threads) trong cấu hình crawl (Configuration > Speed).

- Thử đổi user agent sang Chrome hoặc Googlebot để xem liệu giới hạn này có áp dụng với user agent khác không.

- Lên lịch crawl vào thời điểm máy chủ ít tải (ví dụ ban đêm) để tránh giới hạn yêu cầu.

- Có thể thêm độ trễ (delay) giữa các yêu cầu để giảm tải cho server.

Lý do

Máy chủ giới hạn số lượng yêu cầu từ một địa chỉ IP hoặc user agent trong khoảng thời gian nhất định để tránh quá tải. Giảm tốc độ gửi yêu cầu hoặc đổi user agent có thể giúp tránh bị chặn do giới hạn này.

13. 500 / 502 / 503 – Lỗi máy chủ nội bộ

Máy chủ báo lỗi với yêu cầu đang xử lý.

Điều cần kiểm tra

- Trang web có thể truy cập được trên trình duyệt không? Hoặc trang có đang gặp sự cố?

Điều nên thử

- Nếu trang có thể xem trên trình duyệt, thử thay đổi user agent của SEO Spider sang Chrome hoặc Googlebot để kiểm tra xem trang có phản hồi khác khi nhận dạng là bot không.

Lý do

Một số website có thể gửi lỗi cho SEO Spider như biện pháp bảo vệ hoặc do các lỗi server khác. Thử thay đổi user agent có thể giúp xác định hoặc khắc phục vấn đề.

Qua bài viết này, bạn đã hiểu rõ hơn về các http status code crawl cơ bản cùng vai trò quan trọng của chúng trong quá trình kiểm tra và tối ưu website với công cụ Screaming Frog SEO Spider. Việc nắm bắt chính xác ý nghĩa của từng mã trạng thái sẽ giúp bạn nhanh chóng phát hiện và khắc phục các vấn đề khi crawl, từ đó nâng cao hiệu quả SEO kỹ thuật và quản lý nội dung hiệu quả hơn. Công Ty Seo Lenart tin tưởng rằng với kiến thức seo và công cụ phù hợp, bạn sẽ có chiến lược quản trị website chuyên nghiệp, phát triển bền vững trong tương lai.